既製品のソリューションがあるのに、なぜカスタムを選ぶのか?

- 柔軟性: 特定のユースケースやユーザーレベルに合わせて制限を調整

- パフォーマンス: インフラストラクチャやトラフィックパターンに最適化

- コントロール: API消費の管理方法を細かく調整

- 学習: APIの動作や使用パターンについて深い洞察を得る

同じページに立ったところで、詳細に入りましょう!

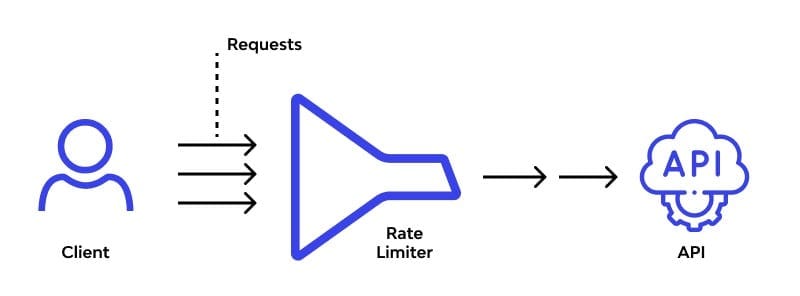

基礎: レート制限アルゴリズム

レート制限ソリューションの中心にはアルゴリズムがあります。いくつかの人気のあるものを見て、どのように実装できるかを見てみましょう:

1. トークンバケットアルゴリズム

一定の速度でトークンが溜まるバケツを想像してください。各APIリクエストはトークンを消費します。バケツが空の場合、リクエストは拒否されます。シンプルですが効果的です!

import time

class TokenBucket:

def __init__(self, capacity, fill_rate):

self.capacity = capacity

self.fill_rate = fill_rate

self.tokens = capacity

self.last_fill = time.time()

def consume(self, tokens):

now = time.time()

time_passed = now - self.last_fill

self.tokens = min(self.capacity, self.tokens + time_passed * self.fill_rate)

self.last_fill = now

if self.tokens >= tokens:

self.tokens -= tokens

return True

return False

# 使用例

bucket = TokenBucket(capacity=100, fill_rate=10) # 100トークン、毎秒10トークン補充

if bucket.consume(1):

print("リクエスト許可")

else:

print("レート制限超過")

2. リーキーバケットアルゴリズム

底に小さな穴があるバケツを考えてみてください。リクエストがバケツを満たし、一定の速度で「漏れ」出ます。バケツが溢れると、受信リクエストはドロップされます。

from collections import deque

import time

class LeakyBucket:

def __init__(self, capacity, leak_rate):

self.capacity = capacity

self.leak_rate = leak_rate

self.bucket = deque()

self.last_leak = time.time()

def add(self):

now = time.time()

self._leak(now)

if len(self.bucket) < self.capacity:

self.bucket.append(now)

return True

return False

def _leak(self, now):

leak_time = (now - self.last_leak) * self.leak_rate

while self.bucket and self.bucket[0] <= now - leak_time:

self.bucket.popleft()

self.last_leak = now

# 使用例

bucket = LeakyBucket(capacity=5, leak_rate=0.5) # 5リクエスト、2秒ごとに1つ漏れる

if bucket.add():

print("リクエスト許可")

else:

print("レート制限超過")

3. 固定ウィンドウカウンター

これは簡単です: 時間を固定ウィンドウに分け、それぞれのリクエストをカウントします。新しいウィンドウが始まるとカウンターをリセットします。

import time

class FixedWindowCounter:

def __init__(self, window_size, max_requests):

self.window_size = window_size

self.max_requests = max_requests

self.current_window = time.time() // window_size

self.request_count = 0

def allow_request(self):

current_time = time.time()

window = current_time // self.window_size

if window > self.current_window:

self.current_window = window

self.request_count = 0

if self.request_count < self.max_requests:

self.request_count += 1

return True

return False

# 使用例

counter = FixedWindowCounter(window_size=60, max_requests=100) # 1分間に100リクエスト

if counter.allow_request():

print("リクエスト許可")

else:

print("レート制限超過")

APIゲートウェイでの実装

アルゴリズムが揃ったので、APIゲートウェイに統合する方法を見てみましょう。この例ではFastAPIを使用しますが、他のフレームワークにも適用できます。

from fastapi import FastAPI, Request, HTTPException

from fastapi.middleware.cors import CORSMiddleware

from TokenBucket import TokenBucket

app = FastAPI()

# CORSミドルウェアを追加

app.add_middleware(

CORSMiddleware,

allow_origins=["*"],

allow_credentials=True,

allow_methods=["*"],

allow_headers=["*"],

)

# 各クライアントのレートリミッターを作成

rate_limiters = {}

@app.middleware("http")

async def rate_limit_middleware(request: Request, call_next):

client_ip = request.client.host

if client_ip not in rate_limiters:

rate_limiters[client_ip] = TokenBucket(capacity=100, fill_rate=10)

if not rate_limiters[client_ip].consume(1):

raise HTTPException(status_code=429, detail="レート制限超過")

response = await call_next(request)

return response

@app.get("/")

async def root():

return {"message": "こんにちは、レート制限された世界!"}

このセットアップは、各クライアントIPに対して個別のレートリミッターを作成し、毎秒10トークンの補充率で100リクエストを許可します。

高度な技術と考慮事項

カスタムレート制限ソリューションを実装する際には、次の点に注意してください:

1. 分散レート制限

APIが複数のサーバーで動作している場合、レート制限データを同期する方法が必要です。Redisのような分散キャッシュを使用することを検討してください:

import redis

class DistributedRateLimiter:

def __init__(self, redis_url, key_prefix, limit, window):

self.redis = redis.from_url(redis_url)

self.key_prefix = key_prefix

self.limit = limit

self.window = window

def is_allowed(self, identifier):

key = f"{self.key_prefix}:{identifier}"

current = self.redis.get(key)

if current is None:

self.redis.set(key, 1, ex=self.window)

return True

elif int(current) < self.limit:

self.redis.incr(key)

return True

return False

# 使用例

limiter = DistributedRateLimiter("redis://localhost", "api_limit", 100, 60)

if limiter.is_allowed("user123"):

print("リクエスト許可")

else:

print("レート制限超過")

2. 動的レート制限

サーバーの負荷や他のメトリクスに基づいてレート制限を調整します。これにより、トラフィックスパイク時の過負荷を防ぐことができます:

import psutil

def get_dynamic_rate_limit():

cpu_usage = psutil.cpu_percent()

if cpu_usage > 80:

return 50 # CPUが高負荷のときにレート制限を減少

elif cpu_usage > 60:

return 75

else:

return 100

# レート制限ロジックで使用

dynamic_limit = get_dynamic_rate_limit()

3. ユーザー固有のレート制限

さまざまなユーザーレベルやAPIキーに対して異なるレート制限を実装します:

def get_user_rate_limit(api_key):

user_tier = database.get_user_tier(api_key)

if user_tier == "premium":

return 1000

elif user_tier == "standard":

return 100

else:

return 10

# レートリミッターの初期化時に使用

user_limit = get_user_rate_limit(api_key)

rate_limiter = TokenBucket(capacity=user_limit, fill_rate=user_limit/60)

モニタリングと分析

レート制限システムのモニタリングを実装することを忘れないでください。これにより、アルゴリズムを微調整し、問題を早期に発見することができます。

- レート制限ヒットとニアミスをログに記録

- API使用パターンを追跡

- トラフィックの異常なスパイクや低下に対するアラートを設定

PrometheusやGrafanaのようなツールを使用して、レート制限メトリクスを視覚化することを検討してください:

from prometheus_client import Counter, Histogram

REQUESTS = Counter('api_requests_total', 'Total API requests')

RATE_LIMIT_HITS = Counter('rate_limit_hits_total', 'Total rate limit hits')

LATENCY = Histogram('request_latency_seconds', 'Request latency in seconds')

@app.middleware("http")

async def metrics_middleware(request: Request, call_next):

REQUESTS.inc()

with LATENCY.time():

response = await call_next(request)

if response.status_code == 429:

RATE_LIMIT_HITS.inc()

return response

結論: APIトラフィック制御の技術をマスターする

カスタムレート制限アルゴリズムの実装は、APIリクエストの交響曲を指揮するようなものです。それは繊細さ、絶え間ない調整、そしてAPIの独自のリズムを深く理解することを必要とします。しかし、適切なアプローチを取れば、リソースを保護しつつ、ユーザーに素晴らしい体験を提供する調和のとれたバランスを作り出すことができます。

完璧なレート制限ソリューションは、APIと共に進化するものです。実験を恐れず、データを集め、時間をかけてアルゴリズムを洗練させてください。将来の自分(とサーバー)が感謝するでしょう!

"レート制限の技術は「ノー」と言うことではなく、「今はダメ」と最も優雅に言うことです。" - 匿名のAPIグル

さあ、APIトラフィックのモンスターを手なずけに行きましょう!そして、もしこの獣と戦ったことがあるなら、コメントであなたの戦いの物語を共有してください。結局のところ、最高のレート制限戦略は、現実世界の経験の炎の中で鍛えられるのです。