TL;DR: Rust 1.80の協調スケジューリングの新機能

- タスクのイールドメカニズムの改善

- Tokioのような非同期ランタイムとの統合の向上

- タスク実行の公平性の強化

- タスクスケジューリングを細かく制御するための新しいAPI

協調スケジューリングの課題

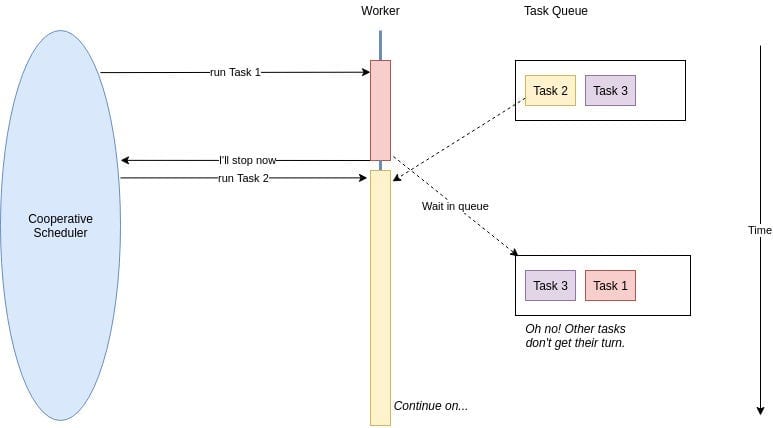

詳細に入る前に、協調スケジューリングが何であるかを思い出してみましょう。Rustの非同期の世界では、タスクはお互いに譲り合い、他のタスクが実行できるように自発的に制御を手放します。これは、準備ができていないときに他の人を先に行かせる礼儀正しい行列のようなものです。

しかし、以前のRustのバージョンでは、この礼儀正しさが時にぎこちない状況を生むことがありました。長時間実行されるタスクが注目を集め、他の重要な操作が待たされることがありました。そこで登場するのがRust 1.80です。このバージョンは、より優雅にこのダンスを行うための新しいトリックを持っています。

新しい仲間: 強化されたイールドメカニズム

Rust 1.80は、タスクがより配慮のある隣人になるための洗練されたイールドメカニズムを導入しました。これらの新機能をどのように活用できるかを簡単に見てみましょう:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct YieldingTask {

yielded: bool,

}

impl Future for YieldingTask {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if !self.yielded {

self.yielded = true;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

この例は、完了する前に一度イールドするタスクを示しています。新しいwake_by_ref()メソッドは、Wakerの不要なクローンを避けることで、より効率的です。

TokioとRust 1.80: 非同期の天国でのマッチ

Tokioを使用している場合(正直、誰が使っていないでしょうか?)、素晴らしい体験が待っています。Rust 1.80の改善は、Tokioのランタイムと見事に調和します。このシナジーをどのように活用できるかを見てみましょう:

use tokio::time::{sleep, Duration};

#[tokio::main]

async fn main() {

let task1 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 1: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let task2 = tokio::spawn(async {

for i in 1..=5 {

println!("Task 2: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let _ = tokio::join!(task1, task2);

}

この例は、TokioのランタイムがRust 1.80の協調スケジューリングとどのようにうまく連携し、タスク間の公平な実行を保証するかを示しています。

公平性: 遊び場の争いだけではない

Rust 1.80の注目すべき機能の一つは、タスク実行の公平性の向上です。もうタスクのいじめっ子がCPU時間を独占することはありません!ランタイムは、タスク間でリソースをより良く分配するようになり、重い負荷の下でのマイクロサービスにとって重要です。

このシナリオを考えてみましょう:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use std::sync::atomic::{AtomicUsize, Ordering};

#[tokio::main]

async fn main() {

let counter = Arc::new(AtomicUsize::new(0));

let tasks: Vec<_> = (0..100).map(|i| {

let counter = Arc::clone(&counter);

tokio::spawn(async move {

loop {

counter.fetch_add(1, Ordering::SeqCst);

if i % 10 == 0 {

sleep(Duration::from_millis(1)).await;

}

}

})

}).collect();

sleep(Duration::from_secs(5)).await;

for task in tasks {

task.abort();

}

println!("Total increments: {}", counter.load(Ordering::SeqCst));

}

この例では、100のタスクを作成し、それぞれが共有カウンターをインクリメントします。一部のタスク(10番ごと)は短時間スリープし、I/O操作をシミュレートします。Rust 1.80の改善された公平性により、この人工的な負荷の下でもタスク間でのインクリメントの分布がより均等になります。

細かい制御: あなたの新しいスーパーパワー

Rust 1.80は、新しいAPIでタスクスケジューリングをより細かく制御できるようにします。これは、非同期コードのための魔法の杖のようなものです。どのように活用できるかを少し見てみましょう:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct ControlledYield {

yields_left: usize,

}

impl Future for ControlledYield {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if self.yields_left > 0 {

self.yields_left -= 1;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

async fn controlled_task(yields: usize) {

ControlledYield { yields_left: yields }.await;

println!("Task completed after {} yields", yields);

}

このControlledYieldのFutureは、タスクが完了する前に何回イールドするかを正確に指定できます。これは、各タスクの協調的な動作を精密に制御するためのノブのようなものです。

落とし穴: 注意が必要!

Rust 1.80の協調スケジューリングの改善は素晴らしいですが、万能薬ではありません。注意すべき落とし穴をいくつか紹介します:

- 過剰なイールドは不要なコンテキストスイッチを引き起こし、パフォーマンスを低下させる可能性があります。

- CPU集約型タスクでのイールド不足は、遅延のスパイクを引き起こす可能性があります。

- ランタイムの公平性に過度に依存すると、マイクロサービスアーキテクチャの根本的な設計問題を隠す可能性があります。

すべてをまとめる: 現実のシナリオ

これらの改善が重い負荷の下でのマイクロサービスにどのように適用できるかを、より現実的な例で見てみましょう:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use tokio::sync::Semaphore;

async fn process_request(id: u32, semaphore: Arc) {

let _permit = semaphore.acquire().await.unwrap();

println!("Processing request {}", id);

// Simulate some work

sleep(Duration::from_millis(100)).await;

println!("Completed request {}", id);

}

#[tokio::main]

async fn main() {

let semaphore = Arc::new(Semaphore::new(10)); // 同時処理を制限

let mut handles = vec![];

for i in 0..1000 {

let sem = Arc::clone(&semaphore);

handles.push(tokio::spawn(async move {

process_request(i, sem).await;

}));

}

for handle in handles {

handle.await.unwrap();

}

}

この例では、1000のリクエストを同時に処理するマイクロサービスをシミュレートしていますが、セマフォを使用して実際の同時処理を10に制限しています。Rust 1.80の改善された協調スケジューリングにより、この重い負荷の下でも各タスクが公平に実行され、単一のリクエストがリソースを独占することを防ぎます。

まとめ: 協調の精神を受け入れよう

Rust 1.80の協調スケジューリングの強化は、重い負荷の下で動作するマイクロサービスにとってゲームチェンジャーです。これらの改善を活用することで、以下のことが可能になります:

- タスク実行の公平性を確保することで遅延スパイクを減少させる

- システム全体の応答性を向上させる

- 非同期コードを最適なパフォーマンスに微調整する

- トラフィックの急増を優雅に処理できる、より堅牢なマイクロサービスを構築する

これらの新機能をマスターする鍵は、練習と実験です。恐れずに飛び込んで、マイクロサービスアーキテクチャをどのように変革できるかを見てみましょう。

考えるための材料

"マイクロサービスの世界では、協力は単なる良いことではなく、生存に不可欠です。"

これらの新しい協調スケジューリングパターンを実装する際に、自問してみてください:

- 現在のマイクロサービスで、改善されたスケジューリングの恩恵を受ける可能性のあるボトルネックをどのように特定できますか?

- これらの新機能を最大限に活用するために、どのメトリクスを監視すべきですか?

- これらの改善についてチームを教育し、非同期Rust開発のベストプラクティスを奨励するにはどうすればよいですか?

これらの質問を継続的に問いかけ、Rust 1.80の機能を探求することで、プレッシャーの下で単に生き残るだけでなく、繁栄するマイクロサービスを構築することができるでしょう。

さあ、これまで以上に協力して進んでください!あなたのマイクロサービス(そしてユーザー)が感謝するでしょう。