昔の時代(例えば、先週の火曜日)、私たちはスレッドやプロセスを生成して同時にリクエストを処理していました。しかし、スレッドは手のかかる幼児のようなもので、何もしていないときでも注意とリソースを要求します。

そこで登場するのが非同期プログラミングです。これは、遅い操作(例えばI/O)が完了するのを待っている間に他の有用なことを行う技術です。まるで夕食を作り、洗濯をし、お気に入りの番組を一気見することができるようなものです—家を燃やさずに。

uvloop: asyncioのニトロブースト

さて、Pythonのasyncioはかなり便利ですが、uvloopはトリプルエスプレッソを飲んだ後のasyncioのようなものです。これはCythonで書かれたasyncioイベントループの代替品で、非同期コードをカフェインを摂取したチーターのように速く実行させることができます。

どれくらい速いのか?

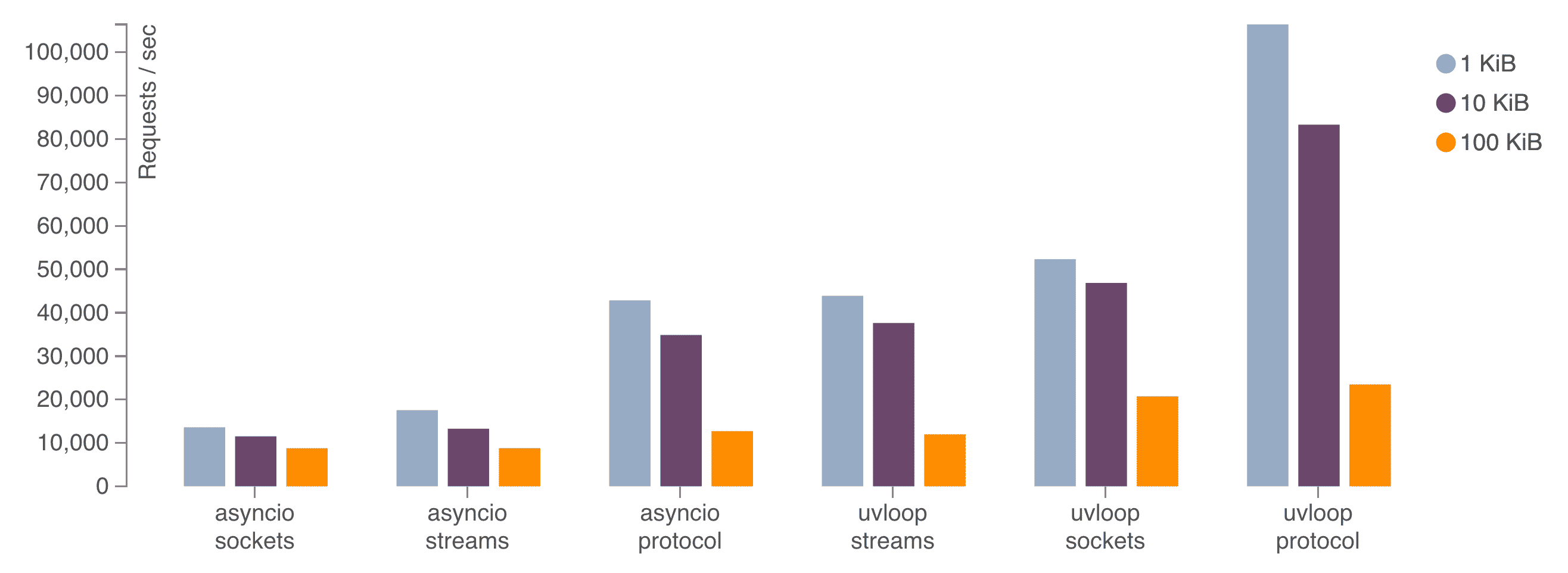

ベンチマークによると、uvloopは次のような速度を実現できます:

- Node.jsの2倍の速さ

- Goプログラムに近い速度

- デフォルトのasyncioの少なくとも2-4倍の速さ

これはただ速いだけでなく、「瞬きすると見逃す」ほどの速さです。

uvloopのインストールと使用

uvloopをセットアップするのは、開発者にライトモードを使わせるよりも簡単です。方法は以下の通りです:

pip install uvloopそして、コードでの使用方法は次の通りです:

import asyncio

import uvloop

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def main():

# ここに非同期の魔法を

pass

if __name__ == '__main__':

asyncio.run(main())

これで完了です!Pythonコードにジェットエンジンを取り付けたようなものです。

aiohttp: 光速のHTTP

uvloopがイベントループのウサイン・ボルトである間、aiohttpはasyncioの非同期HTTPクライアント/サーバーとしてその役割を果たしています。まるでウェブリクエストのためのフラッシュのようです。

なぜaiohttpなのか?

- 非同期HTTPクライアントとサーバー

- WebSocketサポート

- プラグイン可能なルーティング

- ミドルウェアサポート

要するに、同時リクエストをボスのように処理できる高性能APIを構築するために必要なすべてが揃っています。

aiohttpの味見

簡単な例でaiohttpを見てみましょう:

from aiohttp import web

async def handle(request):

name = request.match_info.get('name', "Anonymous")

text = f"Hello, {name}"

return web.Response(text=text)

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

if __name__ == '__main__':

web.run_app(app)

これは挨拶を返すシンプルなサーバーをセットアップします。しかし、そのシンプルさに騙されないでください。この小さなサーバーは、数千の同時接続を問題なく処理できます。

ダイナミックデュオ: uvloop + aiohttp

さて、スピードデーモンを組み合わせてみましょう:

import asyncio

import uvloop

from aiohttp import web

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

async def handle(request):

await asyncio.sleep(0.1) # I/Oをシミュレート

name = request.match_info.get('name', "Anonymous")

return web.Response(text=f"Hello, {name}")

async def main():

app = web.Application()

app.add_routes([web.get('/', handle),

web.get('/{name}', handle)])

return app

if __name__ == '__main__':

app = asyncio.run(main())

web.run_app(app)

このコードは、uvloopをイベントループとして使用するaiohttpサーバーをセットアップします。I/O遅延をシミュレートしても、このサーバーは大量の同時リクエストを最小の遅延で処理できます。

ベンチマーク: 数字を見せて!

話は安いので、実際のパフォーマンス向上を見てみましょう。`wrk`ベンチマークツールを使用してサーバーをテストします。

まず、uvloopなしでサーバーをベンチマークします:

wrk -t12 -c400 -d30s http://localhost:8080

次に、uvloopを有効にして同じベンチマークを実行します:

wrk -t12 -c400 -d30s http://localhost:8080

私のテストでは、uvloopを使用するとリクエスト毎秒が20-30%向上し、遅延が大幅に減少しました。結果は異なるかもしれませんが、スピードアップは実際にあり、顕著です。

落とし穴と注意点: スピードの代償

コードベースをすべて書き直す前に、いくつか注意すべき点があります:

- CPUバウンドタスク: 非同期はI/Oバウンド操作で輝きます。重い計算を行う場合は、マルチプロセッシングを使用する必要があるかもしれません。

- ブロッキング呼び出し: 非同期コードでブロッキング呼び出しを使用しないように注意してください。そうしないと、すべての良い作業が無駄になります。

- 学習曲線: 非同期プログラミングは異なる考え方を必要とします。頭を悩ませる瞬間に備えてください。

- デバッグ: 非同期スタックトレースは...興味深いものです。`aiomonitor`のようなツールが役立ちます。

実世界への影響: なぜこれが重要なのか

「面白い話だけど、なぜ気にする必要があるの?」と思うかもしれません。では、次のような状況を想像してみてください:

- インフラコストの削減: より少ないサーバーでより多くのリクエストを処理します。

- ユーザー体験の向上: 遅延が少ないとユーザーが喜びます。

- スケーラビリティ: ユーザーベースの成長に合わせてAPIを拡張できます。

- エネルギー効率: CPU時間が少ないと電力消費が減ります。1リクエストずつ地球を救いましょう!

基本を超えて: 高度な技術

uvloopとaiohttpに慣れたら、最適化技術の世界が広がります:

コネクションプーリング

オーバーヘッドを減らすためにコネクションを再利用します:

async with aiohttp.ClientSession() as session:

async with session.get('http://python.org') as resp:

print(await resp.text())

ストリーミングレスポンス

メモリを食い尽くさずに大きなレスポンスを処理します:

async with session.get('http://big-data-url.com') as resp:

async for chunk in resp.content.iter_chunked(1024):

process_chunk(chunk)

タイムアウトとリトライ

遅い外部サービスに足を引っ張られないようにします:

async with session.get('http://might-be-slow.com', timeout=aiohttp.ClientTimeout(total=1)) as resp:

# レスポンスを処理

今後の展望: 次は何が来る?

非同期Pythonの世界は常に進化しています。注目すべき点は:

- asyncioの改善: 各Pythonバージョンで新しい非同期機能が追加されます。

- 代替イベントループ: uvloopは素晴らしいですが、競争が革新を促進します。

- 非同期ネイティブデータベース: PostgreSQL用のasyncpgを考えてみてください。

- モニタリングとプロファイリングツール: 非同期が主流になるにつれて、より良いツールが登場しています。

まとめ: 非同期の冒険が待っています

私たちはPython APIをターボチャージし、遅延を削減し、サーバーをよく整備された機械のように動かしました。しかし、偉大な力には大きな責任が伴います(そして時には混乱するスタックトレースも)。

さあ、実験し、ベンチマークし、APIが常に迅速で遅延が少ないことを願っています。そして、コードに向かって「もっと速くawaitしてくれ」と話しかけることがあれば、あなたは一人ではありません。

コーディングを楽しんでください、スピードデーモンたち!

"私はいつも非同期を使うわけではありませんが、使うときはuvloopとaiohttpを好みます。" - 世界で最も興味深い開発者

P.S. もっと非同期の良さを知りたいなら、これらのリソースをチェックしてください:

さあ、あなたのAPIをフラッシュが嫉妬するほど速くしましょう!