デバッグの冒険を始める前に、基本を押さえておきましょう:

書き込み増幅は、アプリケーションが意図したデータ量よりも多くのデータがストレージメディアに書き込まれるときに発生します。

つまり、データベースがあなたを裏切って、要求した以上のデータを書き込んでいるということです。これは単にストレージスペースを無駄にするだけでなく、I/O操作のパフォーマンスを低下させ、SSDをマラソンで履きつぶすスニーカーのように早く消耗させます。

常連の容疑者たち:CassandraとMongoDB

探偵帽をかぶって、2つの人気NoSQLデータベースで書き込み増幅がどのように現れるかを調査しましょう:

Cassandra:圧縮の謎

Cassandraは、ログ構造マージツリー(LSMツリー)ストレージエンジンを使用しており、特に書き込み増幅が発生しやすいです。その理由は以下の通りです:

- 不変のSSTable: Cassandraはデータを不変のSSTableに書き込み、既存のファイルを変更するのではなく新しいファイルを作成します。

- 圧縮: これらのファイルを管理するために、Cassandraは複数のSSTableを1つにマージする圧縮を行います。

- 墓石: Cassandraでの削除は墓石を作成し、これもまた書き込みを増やします!

これがどのように進行するかの簡単な例を見てみましょう:

-- 初期書き込み

INSERT INTO users (id, name) VALUES (1, 'Alice');

-- 更新(新しいSSTableを作成)

UPDATE users SET name = 'Alicia' WHERE id = 1;

-- 削除(墓石を作成)

DELETE FROM users WHERE id = 1;

このシナリオでは、単一のユーザーレコードが異なるSSTableに複数回書き込まれ、圧縮中に書き込み増幅を引き起こす可能性があります。

MongoDB:MMAPの混乱

MongoDB、特に初期バージョンのMMAPストレージエンジンでは、独自の書き込み増幅の問題がありました:

- インプレース更新: MongoDBは可能な限りドキュメントをその場で更新しようとします。

- ドキュメントの成長: ドキュメントが成長して元のスペースに収まらない場合、新しい場所に書き直されます。

- 断片化: これにより断片化が発生し、定期的な圧縮が必要になります。

書き込み増幅を引き起こす可能性のあるMongoDBの例を示します:

// 初期挿入

db.users.insertOne({ _id: 1, name: "Bob", hobbies: ["reading"] });

// ドキュメントを成長させる更新

db.users.updateOne(

{ _id: 1 },

{ $push: { hobbies: "skydiving" } }

);

「Bob」が趣味を追加し続けると、ドキュメントが割り当てられたスペースを超えてしまい、MongoDBがそれを完全に書き直すことになります。

書き込み増幅のデバッグ:ツールの紹介

問題がわかったので、デバッグツールを用意しましょう:

Cassandraの場合:

- nodetool cfstats: SSTableの統計情報を提供し、書き込み増幅を含みます。

- nodetool compactionstats: 進行中の圧縮に関するリアルタイム情報を提供します。

- JMXモニタリング: jconsoleなどのツールを使用して、圧縮やSSTableに関連するCassandraのJMXメトリクスを監視します。

nodetool cfstatsの使用例:

nodetool cfstats keyspace_name.table_name

出力の「Write amplification」メトリックを探します。

MongoDBの場合:

- db.collection.stats(): コレクションの統計情報を提供し、avgObjSizeやstorageSizeを含みます。

- mongostat: リアルタイムのデータベースパフォーマンス統計を表示するコマンドラインツールです。

- MongoDB Compass: データベースのパフォーマンスとストレージ使用量に関する視覚的な洞察を提供するGUIツールです。

MongoDBシェルでのdb.collection.stats()の使用例:

db.users.stats()

「size」と「storageSize」の比率に注目して、潜在的な書き込み増幅を評価します。

書き込み増幅の獣を手なずける

問題を特定したので、いくつかの解決策を見てみましょう:

Cassandraの場合:

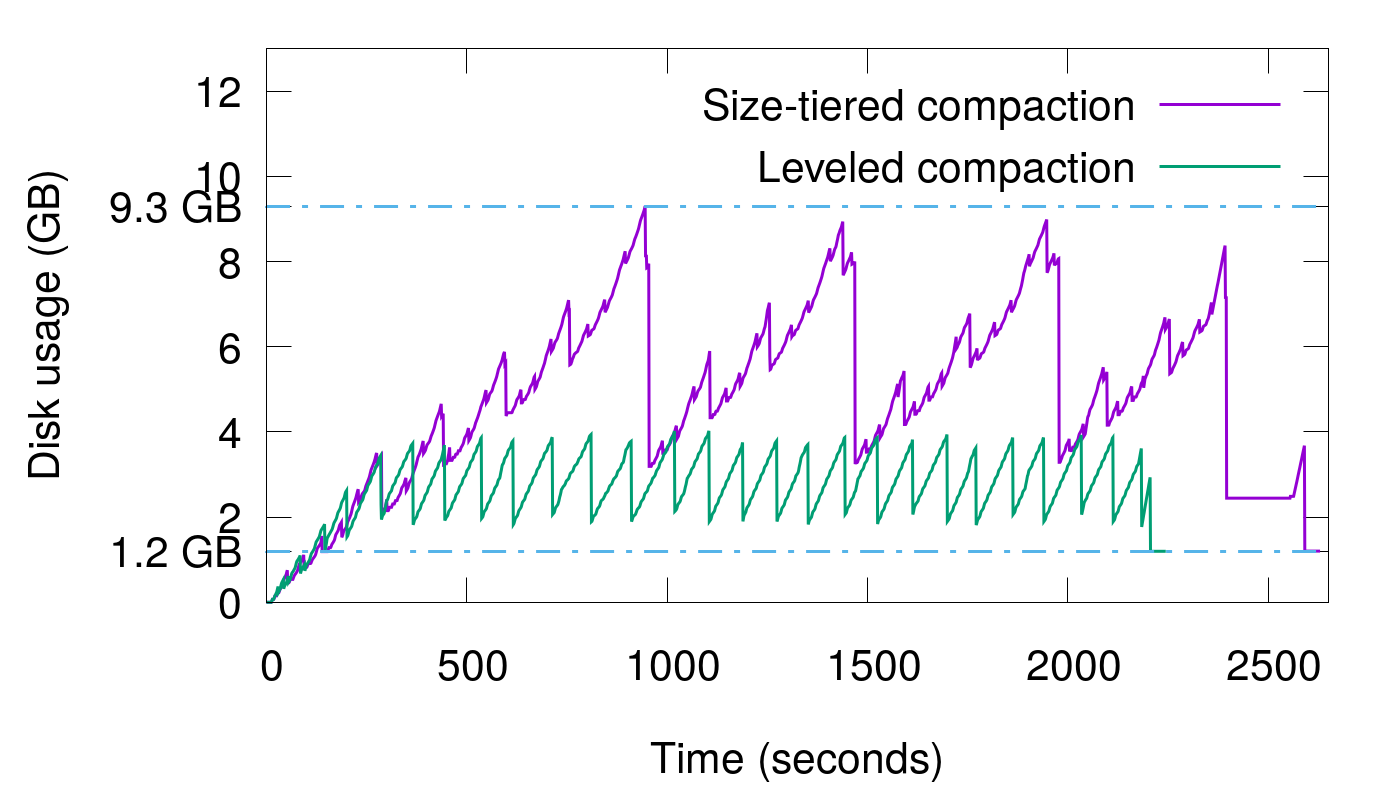

- 圧縮戦略の調整: ワークロードに適した圧縮戦略(SizeTieredCompactionStrategy、LeveledCompactionStrategy、TimeWindowCompactionStrategy)を選択します。

- 墓石処理の最適化: gc_grace_secondsを調整し、可能な場合はバッチ削除を使用します。

- SSTableの適正サイズ化: compaction_throughput_mb_per_secとmax_thresholdの設定を調整します。

圧縮戦略を変更する例:

ALTER TABLE users WITH compaction = {

'class': 'LeveledCompactionStrategy',

'sstable_size_in_mb': 160

};

MongoDBの場合:

- WiredTigerストレージエンジンの使用: MMAPと比較して書き込み増幅の処理がより効率的です。

- ドキュメントの事前割り当ての実装: ドキュメントが成長することがわかっている場合は、事前にスペースを割り当てます。

- 定期的な圧縮: compactコマンドを定期的に実行してスペースを回収し、断片化を減らします。

MongoDBでの圧縮実行の例:

db.runCommand( { compact: "users" } )

プロットツイスト:書き込み増幅が実際に良い場合

キーボードをしっかり握ってください。ここからが面白いところです:時には、書き込み増幅が有益なこともあります!特定のシナリオでは、追加の書き込みを犠牲にしても読み取りパフォーマンスを向上させることが賢明な選択となることがあります。

例えば、Cassandraでは、圧縮により読み取り時にチェックする必要のあるSSTableの数が減少し、クエリ応答が速くなる可能性があります。同様に、MongoDBのドキュメントの書き直しは、ドキュメントの局所性を改善し、読み取りパフォーマンスを向上させることがあります。

重要なのは、特定のユースケースに適したバランスを見つけることです。スイスアーミーナイフと専門ツールの選択のように、時には多機能性が余分な負担に見合う価値があります。

まとめ:落ち着いてデバッグを続けよう

NoSQLデータベースの書き込み増幅は、コードに何度も現れる奇妙なバグのようなものです。イライラしますが、正しいアプローチで克服可能です。原因を理解し、適切なデバッグツールを使用し、ターゲットを絞った解決策を実施することで、データベースの書き込みを制御し、ストレージコストが急上昇するのを防ぐことができます。

覚えておいてください、すべてのデータベースとワークロードはユニークです。あるものに効果的なものが、他のものには効果がないかもしれません。実験、測定、最適化を続けてください。そして、もしかしたら、チーム内で書き込み増幅のウィスパラーになるかもしれません。

さあ、野生の書き込みをデバッグしに行きましょう!あなたのSSDが感謝するでしょう。

"デバッグは、あなたが犯人でもある犯罪映画の探偵になるようなものです。" - Filipe Fortes

デバッグを楽しんでください!