昔ながらの方法: 思い出の小道をたどる

サービスを更新するたびに、うまくいくことを祈っていたあの頃を覚えていますか?実際には、あの頃はそれほど良い時代ではありませんでした。従来の更新プロセスを振り返ってみましょう:

- 新しいバージョンをデプロイする

- ヘルスチェックを待つ

- トラフィックを徐々にシフトする

- DevOpsの神に祈る

- 問題が発生した場合はロールバックする

この方法は機能しましたが、まるで砂利道のようにスムーズではありませんでした。ここで登場するのが、Kubernetes 1.32のプロアクティブなワークロードシフトです。

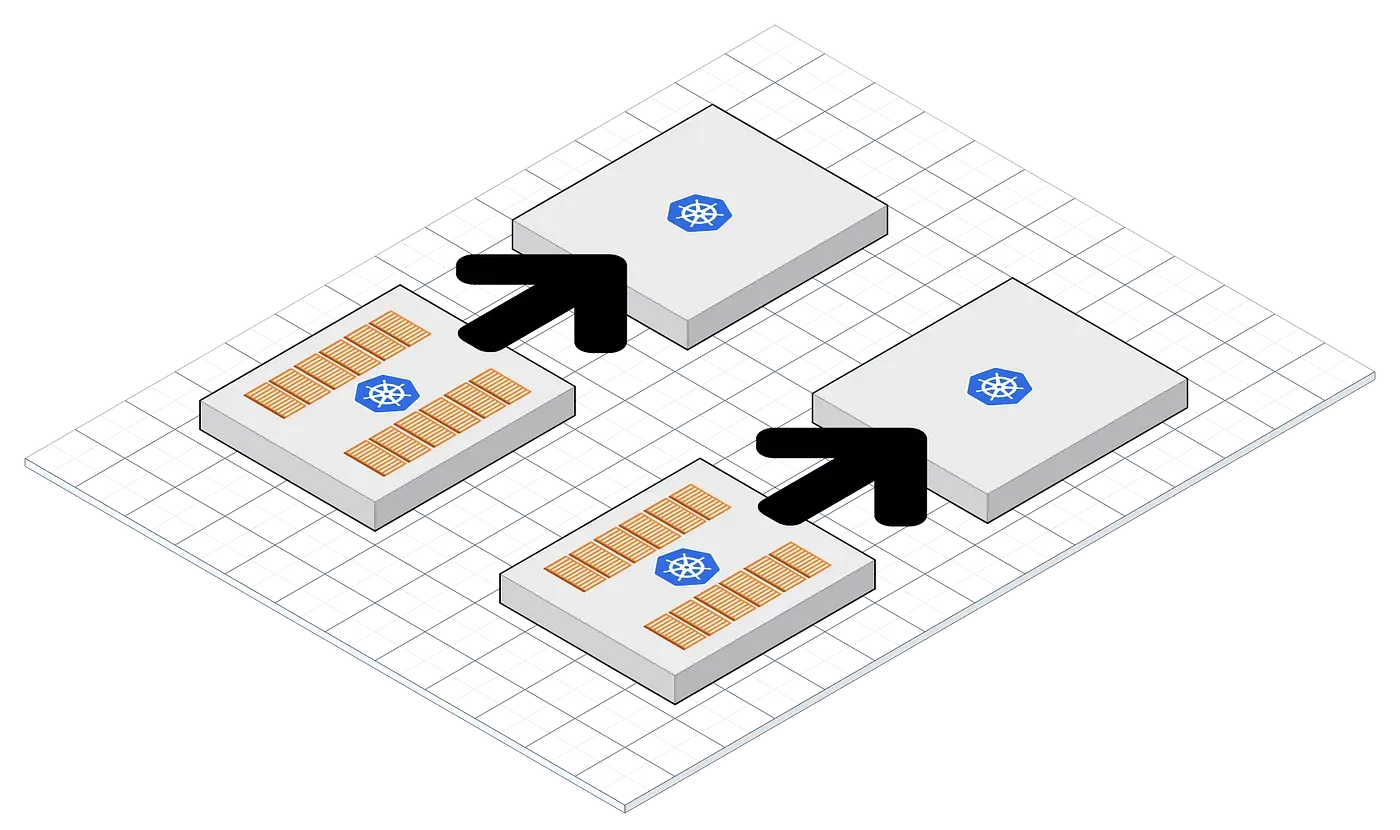

プロアクティブなワークロードシフト: 新しいホットな機能

では、この魔法のような機能とは一体何でしょうか?要するに、更新が行われる前にクラスターを準備する方法です。以下のように動作します:

- 新しいポッドを事前にウォームアップする

- 受信リクエストを徐々にシフトする

- 新しいバージョンにシームレスに移行する

- 古いポッドを優雅に終了する

詳しく見ていきましょう。

1. ポッドの事前ウォームアップ: 早起きは三文の徳

Kubernetes 1.32では、必要になる前に新しいポッドを作成して初期化することができます。これにより、新しいバージョンはいつでもすぐに使用できる状態になります。

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 0

template:

metadata:

annotations:

k8s.v1.cni.cncf.io/networks: macvlan-conf

spec:

containers:

- name: my-app

image: my-app:v2

ports:

- containerPort: 8080

initContainers:

- name: init-myservice

image: busybox:1.28

command: ['sh', '-c', 'until nc -z myservice 80; do echo waiting for myservice; sleep 2; done;']

この例では、initコンテナを使用して、メインコンテナが開始する前にサービスの依存関係が準備完了であることを確認しています。

2. トラフィックの徐々なシフト: ゆっくりと着実に

新しいポッドがウォームアップされたら、Kubernetes 1.32はトラフィックを徐々にシフトし始めます。ここで魔法が起こります:

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: my-ingress

annotations:

kubernetes.io/ingress.class: nginx

nginx.ingress.kubernetes.io/canary: "true"

nginx.ingress.kubernetes.io/canary-weight: "10"

spec:

rules:

- host: myapp.example.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: my-app-v2

port:

number: 80

このIngress設定は、Kubernetesに新しいバージョンにトラフィックの10%を送信するよう指示します。新しいバージョンに自信がつくにつれて、この割合を徐々に増やすことができます。

3. シームレスな移行: ボスのように

新しいバージョンが安定していることが確認されたら、トラフィックシフトを増やして、すべてのリクエストが新しいポッドによって処理されるようにします。最高の部分?ユーザーは何も気づきません。

4. 優雅な終了: ポッドを置き去りにしない

最後に、Kubernetes 1.32は古いポッドが優雅に終了することを保証し、シャットダウンする前に進行中のリクエストを処理することができます。

apiVersion: policy/v1

kind: PodDisruptionBudget

metadata:

name: my-app-pdb

spec:

maxUnavailable: 1

selector:

matchLabels:

app: my-app

このPodDisruptionBudgetは、更新プロセス中に最大で1つのポッドが利用できないことを保証し、サービスの可用性を維持します。

しかし、まだあります!

Kubernetes 1.32のプロアクティブなワークロードシフトは、スムーズな更新だけでなく、いくつかの追加の利点ももたらします:

- リソース効率: ポッドを事前にウォームアップすることで、必要なときにリソースが利用可能であることを保証し、過剰なプロビジョニングを避けることができます。

- 信頼性の向上: トラフィックを徐々にシフトすることで、すべてのユーザーに影響を与える前に問題を早期に発見できます。

- テストの改善: A/Bテストやカナリアリリースを簡単に実行し、新しいバージョンのパフォーマンスに関する実データを収集できます。

注意点と落とし穴: すべてが順風満帆ではありません

プロアクティブなワークロードシフトを全面的に採用する前に、いくつか考慮すべき点があります:

- リソース消費: ポッドを事前にウォームアップするには、更新プロセス中に追加のリソースが必要です。クラスターがそれを処理できることを確認してください。

- 設定の複雑さ: プロアクティブなワークロードシフトを設定するには、慎重な設定が必要です。まずは非本番環境で徹底的にテストしてください。

- ステートフルアプリケーション: ステートレスなマイクロサービスには最適ですが、ステートフルアプリケーションには追加の考慮が必要かもしれません。

"大いなる力には大いなる責任が伴う。" - ベンおじさん(そしてすべてのDevOpsエンジニア)

すべてをまとめる: 実際の例

重要な支払い処理サービスを更新しているとしましょう。プロアクティブなワークロードシフトをどのように活用するかを見てみましょう:

- 新しいバージョンをゼロレプリカでデプロイする

- 古いバージョンを維持しながら新しいバージョンを徐々にスケールアップする

- Ingressルールを使用して、新しいバージョンに少量のトラフィックをシフトする

- エラーやパフォーマンスの問題を監視する

- 新しいバージョンへのトラフィックを徐々に増やす

- トラフィックが100%新しいバージョンに移行したら、古いバージョンをスケールダウンして削除する

デプロイメントのスニペットは次のようになります:

apiVersion: apps/v1

kind: Deployment

metadata:

name: payment-service-v2

spec:

replicas: 0 # ゼロレプリカで開始

selector:

matchLabels:

app: payment-service

version: v2

template:

metadata:

labels:

app: payment-service

version: v2

spec:

containers:

- name: payment-service

image: payment-service:v2

ports:

- containerPort: 8080

readinessProbe:

httpGet:

path: /health

port: 8080

initialDelaySeconds: 10

periodSeconds: 5

resources:

requests:

cpu: 100m

memory: 128Mi

limits:

cpu: 500m

memory: 512Mi

その後、Horizontal Pod Autoscaler (HPA)を使用して、CPU使用率やカスタムメトリクスに基づいてレプリカの数を徐々に増やします。

未来は今: プロアクティブなワークロードシフトを受け入れる

Kubernetes 1.32のプロアクティブなワークロードシフトは、真のゼロダウンタイムアップグレードを目指す人々にとってゲームチェンジャーです。この機能を活用することで:

- 更新時のリスクを最小限に抑える

- ダウンタイムを排除してユーザーエクスペリエンスを向上させる

- デプロイメントプロセスに対する自信を高める

- 夜も安心して眠れる(結果は異なる場合があります)

では、Kubernetesのデプロイメントを次のレベルに引き上げる準備はできていますか?プロアクティブなワークロードシフトを試してみて、更新の不安にさよならを告げましょう!

考えるための材料

自分のクラスターでプロアクティブなワークロードシフトを実装する際には、次の質問を考慮してください:

- このアプローチを既存のCI/CDパイプラインにどのように統合できますか?

- 成功した移行を確保するためにどのメトリクスを監視すべきですか?

- この機能は将来のKubernetesリリースでどのように進化するでしょうか?

Kubernetesの世界は常に進化しています。好奇心を持ち続け、実験を続け、学び続けましょう。シフトを楽しんでください!