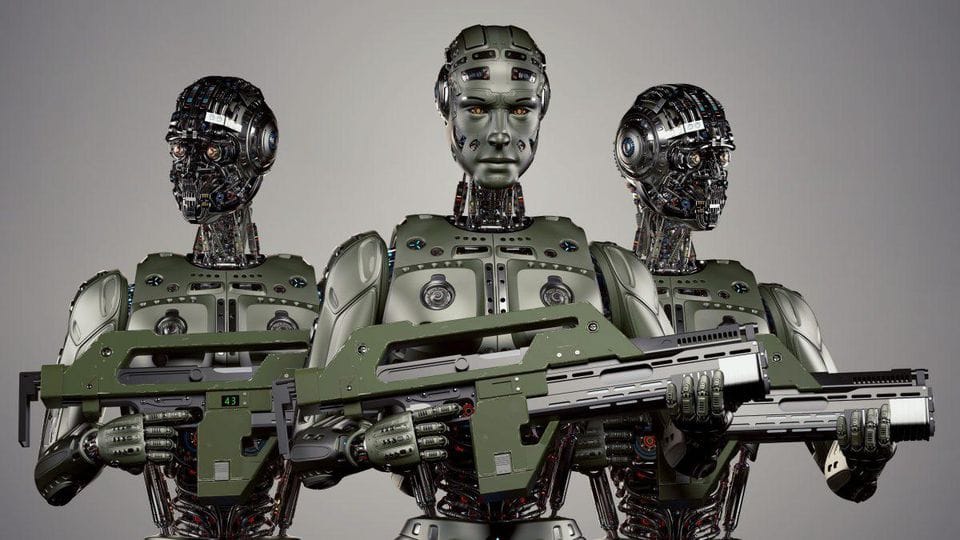

自律兵器システムは、人間の介入なしに目標を選択し攻撃できる軍事プラットフォームです。自動運転車の致命的な親戚と考えてください。交通をナビゲートする代わりに、戦場をナビゲートしています。そして、衝突を避ける代わりに、まあ、言わんとすることはわかるでしょう。

これらのシステムは以下のようなものがあります:

- 敵の位置を特定し攻撃する自律ドローン

- 飛行中に軌道を調整できるAI搭載ミサイルシステム

- 国境や重要施設を守るロボット哨兵

ここでの重要な特徴は自律性です。リモートコントロールされた兵器とは異なり、AWSは事前にプログラムされたパラメータとリアルタイムのデータ分析に基づいて自ら決定を下します。

倫理的な難題

基本を押さえたところで、倫理的な問題に足を踏み入れましょう。AWSの開発と配備は、最も経験豊富な哲学者でさえ頭を悩ませるような多くの道徳的な問題を引き起こします。

1. 責任のギャップ

自律兵器が誤りを犯した場合、誰が責任を負うのでしょうか?アルゴリズムを書いたプログラマー?それを配備した軍の指揮官?AI自体?この「責任のギャップ」は倫理的議論の大きな障害です。

"大いなる力には大いなる責任が伴う" - スパイダーマンのベンおじさん

しかし、その力が責任の概念を理解しないAIによって行使される場合はどうなるのでしょうか?

2. 武力紛争の敷居の低下

戦争が人間の兵士ではなくロボットで戦われる場合、軍事行動はより受け入れやすくなるのでしょうか?AWSは武力紛争の敷居を下げ、戦争をより頻繁にする可能性があるという懸念があります。

3. 人間の判断力の欠如

人間は文脈や微妙なニュアンス、致命的な力を使用する決定に影響を与える可能性のある最後の瞬間の変化を考慮に入れることができます。AIにこれらの生死に関わる決定を任せることが本当にできるのでしょうか?

4. 悪用の可能性

誤った手に渡れば、AWSは抑圧、テロ、その他の悪意ある目的に使用される可能性があります。先進的な軍事技術の民主化は両刃の剣です。

現在の規制状況

では、戦争におけるAIを規制することは可能でしょうか?短い答えは:試みていますが、複雑です。

現在、AWSを特に規制する国際条約はありません。しかし、いくつかの取り組みが進行中です:

- 特定通常兵器使用禁止条約(CCW)は2014年からAWSについて議論しています

- キラーロボット禁止キャンペーンは完全自律兵器の事前禁止を推進しています

- ベルギーやルクセンブルクのような国は、すでに軍事教義でAWSを禁止しています

課題は、効果的でありながら急速な技術進歩に対応できる柔軟な規制を作成することにあります。

潜在的な規制アプローチ

戦争におけるAIを規制するためのいくつかの方法を探ってみましょう:

1. 国際条約

包括的な国際条約は、AWSの開発と使用に関する明確なガイドラインを設定することができます。これには以下が含まれる可能性があります:

- 自律兵器の定義

- AWSの交戦規則

- 問題が発生した場合の責任メカニズム

2. 「人間の介入」要件

すべてのAWS操作に人間の監視を義務付けることで、いくつかの倫理的懸念に対処できるかもしれません。これはさまざまなレベルで実施可能です:

def autonomous_weapon_system(target):

if human_approval():

engage_target(target)

else:

stand_down()

def human_approval():

# この関数は人間のオペレーターが行動を承認することを要求します

return input("目標の攻撃を承認しますか? (y/n): ") == 'y'

3. 倫理的AI設計

AIシステムの基本構造に倫理的考慮を組み込むことで、いくつかのリスクを軽減できるかもしれません。これには以下が含まれる可能性があります:

- 戦争の法則と交戦規則のプログラミング

- 堅牢なフェイルセーフと中止メカニズムの実装

- 透明性と監査可能性を考慮したシステム設計

4. 国際監視機関

国際原子力機関の核不拡散における役割に似た、AWSの開発と配備を監視する独立した国際機関を設立することができます。

今後の道のり

戦争におけるAIの規制は非常に困難な課題ですが、無視することはできません。技術が急速に進化する中で、倫理的および規制の枠組みもそれに追いつく必要があります。

将来のための重要な考慮事項は以下の通りです:

- 学際的な協力: 倫理学者、技術者、政策立案者、軍事専門家が協力して効果的な規制を策定する必要があります。

- 透明性: AWSを開発する国は、その能力と意図について透明性を持つべきです。

- 継続的な対話: 技術が進化するにつれて、それを規制するアプローチも進化するべきです。定期的な国際的な議論が重要です。

- 公共の認識: AWSの影響は専門家だけの関心事であってはなりません。公共の理解と意見が重要です。

考えるための材料

自律兵器の倫理についての深い考察を締めくくるにあたり、考えるべきいくつかの質問を提示します:

- 戦争において人間よりも倫理的な決定を下せるAIシステムを作ることは可能でしょうか?

- AWSの潜在的な利益(人間の犠牲者を減らすなど)と倫理的リスクをどのようにバランスさせるべきでしょうか?

- AWSの開発がAIの軍拡競争を引き起こす可能性はありますか?もしそうなら、それをどのように防ぐべきでしょうか?

自律兵器システムに関する議論はまだ終わっていません。技術者として、これらの倫理的な質問に取り組むことが重要です。結局のところ、今日書くコードが明日の戦場を形作るかもしれません。

"本当の問題は機械が考えるかどうかではなく、人間が考えるかどうかである。" - B.F.スキナー

私たちの仕事の影響について深く考えていることを確認しましょう。戦争の未来、そしておそらく人類そのものがそれにかかっているかもしれません。